La scorsa settimana Meta ha rilasciato su GitHub quattro demo di Movement per Unity che consentono agli sviluppatori di provare le nuove funzionalità.

A questo link è possibile scaricare l’apk con le demo.

Cos’è Movement SDK per Unity

Movement SDK è un set di strumenti che consente agli sviluppatori di poter implementare le funzionalità di:

- Face tracking (solo su Quest Pro)

- Eye tracking (solo su Quest Pro)

- Body tracking (su Quest Pro e Quest 2)

Il face tracking consente di rimappare le espressioni dell’utente rilevate dal visore sulla struttura facciale di avatar più o meno realistici.

Similmente l’eye tracking riproduce i movimenti degli occhi sull’avatar, ma aggiunge la possibilità di ottenere il contatto visivo, portando l’interazione ad un livello superiore. Secondo Meta i dati relativi al tracciamento degli occhi restano sul dispositivo e vengono cancellati quando non sono più necessari.

Per quanto riguarda il body tracking il nome è un po’ fuorviante in quanto gambe e piedi non vengono tracciati e il bacino lo è solo se ancorato ad un punto fisso come una sedia. Questa tecnologia richiede una grossa dose di machine learning per evitare gli errori più comuni nell’applicazione della cinematica inversa (determinazione della posizione di un’articolazione data la lunghezza e la posizione delle estremità).

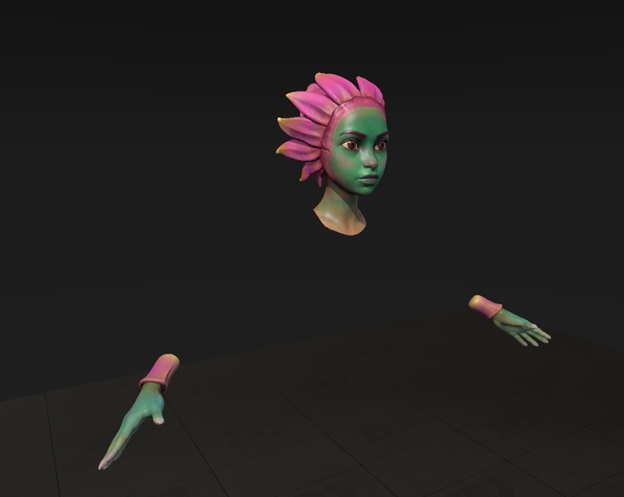

Aura

Aura è la demo mostrata ai pochissimi influencer VR che sono stati invitati a provare Quest Pro in anteprima per dimostrare eye e face tracking.

Questa demo mostra un personaggio di una ragazza aliena in piedi di fronte all’utente che riproduce specularmente le espressioni facciali e il movimento di mani ed occhi in tempo reale.

Qui ci sono i dettagli delle funzionalità utilizzate.

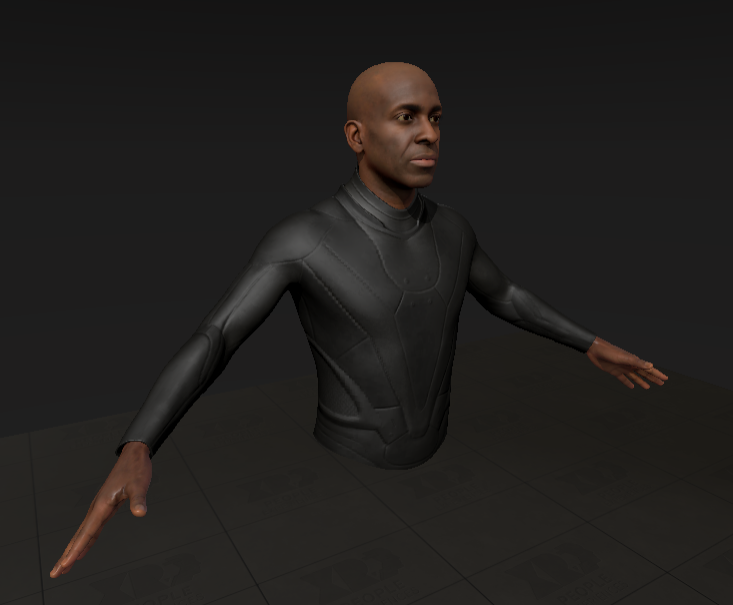

High Fidelity

Come nella demo precedente il personaggio, questa volta ad alta definizione, viene mostrato in piedi di fronte all’utente e ne riproduce i movimenti facciali e degli occhi, ma in più vengono rese anche le posizioni di braccia e torso, calcolati in base all’inclinazione di visore e controller.

Qui ci sono i dettagli delle funzionalità utilizzate.

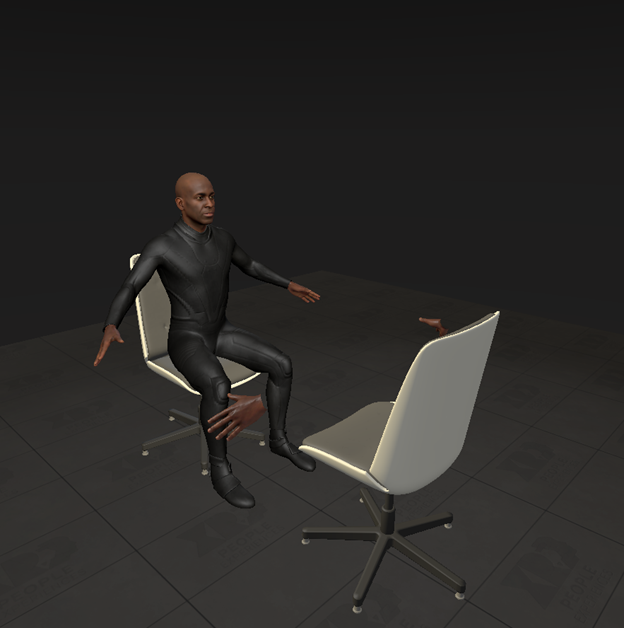

Hip Pinning

Questa demo è molto simile a quella precedente, ma il soggetto è seduto, i movimenti del suo bacino sono tracciati ed è ancorato ad una sedia.

Qui ci sono i dettagli delle funzionalità utilizzate.

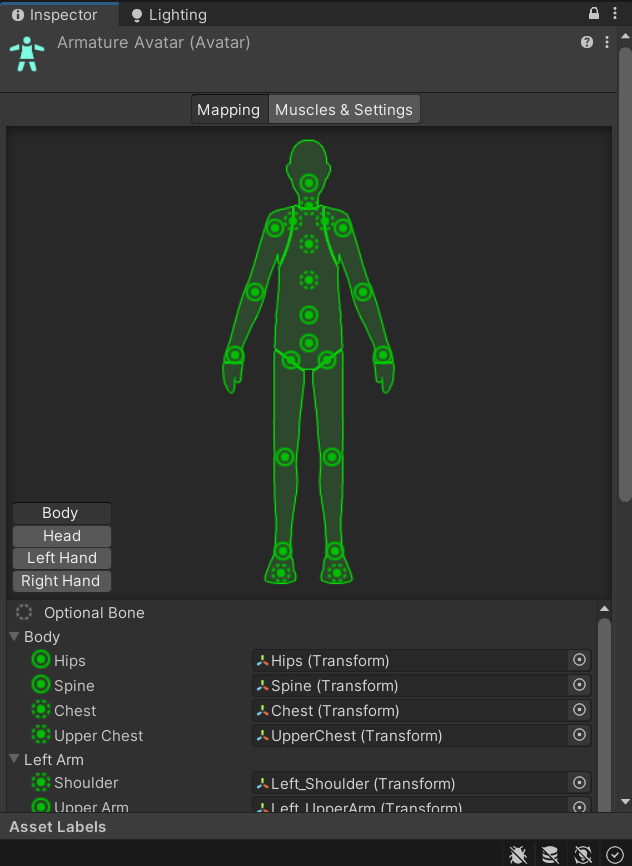

Bone Retargeting

In questa demo viene mostrato un robot umanoide in piedi per dimostrare la funzionalità che consente di riprodurre i movimenti dell’utente, ma applicando uno scheletro con struttura diversa.

Purtroppo la demo compilata non consente di cambiare la propria altezza per cui il robot potrebbe essere troppo alto o troppo basso rispetto a chi lo usa.

Qui ci sono i dettagli delle funzionalità utilizzate.

Continua a seguirci per le ultime novità sulla VR.

Iscrivetevi al nostro canale Discord per restare sempre aggiornati sulle ultime novità e stare in compagni di appassionati come voi!

Link: Gruppo VR-ITALIA